Dobra strona internetowa to dużo więcej niż jej pozytywna ocena wizualna. Na jakościową stronę składa się dużo więcej aspektów których dobre wykonanie zależy tak naprawdę od wykonawcy. Zobacz na co, oprócz ciekawego layoutu, zwracamy uwagę przy naszych projektach.

Wydajna strona www

Świat oprogramowania www oferuje bardzo szeroki zasób możliwości zwiększenia wydajności stron internetowych, wystarczy z nich skorzystać. Projekty wykonane przez nas wykorzystują możliwości przechowywania danych w pamięci, ponieważ dostęp do takich danych trwa setne ułamki sekundy. Strony minimalizują również ograniczenia sieci komupterowych minimalizując rozmiar pobieranych stron. Bardzo ważną cechą wydajnej strony internetowej jest również ograniczenie do minimum ilości zapytań http. Każda strona zawiera dodatkowe pliki, tj. arkusze stylów, pliki javascript czy pliki obrazków które są pobierane przez przeglądarkę jako oddzielne zapytania. Redukcja ilości takich zapytań korzystnie wpływa na całkowity czas pobrania strony ze względu na czas oczekiwania na ustanowienie połączenia.

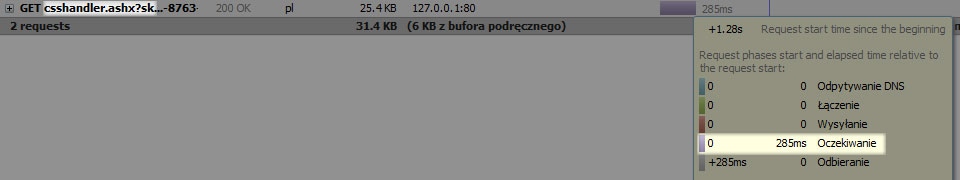

Krótki przykład pokazujący całkowity czas ładowania treści z połączonym zasobem css:

Czas oczekiwania na pobranie jednego, połączonego pliku to 285ms, a sam plik składa się z 30 miejszych plików css. Dzięki zabiegowi łącznienia plików przyspieszamy ładowanie strony o przeszło 8 sekund! (285ms x 29 plików)

Bezpieczeństwo

Nakład środków na bezpieczeństwo jest wprost proporcjonalny do popularności serwisu, ponieważ im serwis ma większą popularność, tym zwiększa się liczba osób chcąca złamać jego zabezpieczenia. Co my robimy, aby zapewnić elementarne minimum bezpieczeństwa?

-

Wybór oprogramowania W naszej pracy wybieramy tylko narzędzia, za które ktoś odpowiada, czyli w kluczowych elementach systemu unikamy rozwiązań open source’wych takich jak php, czy mysql - rozwiązań w których pierwszy punkt regulaminu mówi o przeniesieniu odpowiedzialności na użytkownika, - oprogramowania których kod źródłowy jest dostępny publicznie.

-

Tworzenie kodu odpornego na popularne ataki typu sql injection, czy xss Znając metodologię popularnych ataków na serwisy www, tworzymy strony które od początku są na nie odporne.

-

Słabe ogniwo - człowiek Ważnym elementem bezpiecznego serwisu jest wykorzystanie technik wymuszających na jego użytkownikach dbanie o bezpieczeństwo swoich danych, tj. wymaganie bezpiecznych haseł, sprawdanie protokołu https, walidacja danych, itp.

Wykorzystanie nowych technologii

Nie sztuką jest znać wszystkie najnowsze wzorce, sztuką jest ich umiejętne wykorzystanie. Nawet najbardziej efektownie wyglądające elementy, wykorzystane w zły sposób, są nieefektywne. Dlatego sztuką jest wiedzieć co, w jaki sposób i gdzie wykorzystać, tak aby podnieść użyteczność i profesjonalizm strony.

Skalowalność i koszty konserwacji

Dla, tak zwanych, przyszłościowych projektów, bardzo ważna jest jakość kodu, jego rozszerzalność i skalowalność. Bardzo wiele projektów w pierwszej fazie projektu jest nastawione na maksymalizację zysku, przez co kod jest niedbale napisany i bez sensu. W następstwie czego, klient musi słono płacić za wprowadzanie kolejnych modyfikacji, nierzadko przewyższających koszty początkowe projektu. Im więcej poprawek zostanie wprawadzonych, tym koszty kolejnych będą jeszcze większe prowadząc niejednokrotnie do napisania projektu od nowa. Black House jako firma nastawiona na długofalową wspópracę dba o kod swoich klientów.

Skalowalność a wydajność

Do pewnego poziomu wzrost wydajności jest osiągany kosztem jakości kodu. Mimo wszystko, dla długo falowych projektów na pierwszym miejscu stawiamy skalowalność kodu, ponieważ dużo taniej można podnieść wydajność aplikacji - poprzez ulepszenie sprzętu, niż obniżyć koszty kolejnych funkcjonalności.

Wsparcie dla SEO (Search Engine Optimalization)

Od początków SEO w Polsce większość stron swoje miejsce w wynikach wyszukiwania zawdzięcza systemom wymiany linków. Amatorskie jak i po części profesjonalne firmy pomijają optymalizację SEO w procesie tworzenia strony. Amatorzy - z powodu braku elementarnej wiedzy, profesjonaliści - prawdopodobnie z chęci cięcia kosztów. Jest to o tyle krzywdzące dla klientów, ponieważ optymalizacja na etapie projektowania jest stosunkowo tania i zapewnia długofalowy zysk. Analizycy Google (99% polskiego rynku wyszukiwarek) ciągle pracują nad algorytmem indeksowania stron dążąc do promowania witryn tylko i wyłącznie dobrze zaprojektowanych - zgodnie z własnym regulaminem. Całość nosi wdzięczną nazwę: White Hat Seo. Większość firm pozycjonerskich stosuje techniki Black Hat Seo które w niedalekiej przyszłości zostaną wykluczone przez Google.